"エッジAI"とは

エッジAIの背景

しかし ディープラーニングなどの従来のAIでは、豊富なデータを蓄積・処理できるクラウドサーバー、並列計算に適したGPUといったリッチなコンピュータリソースを必要とする ため、マイコンなどの従来のコンピュータで制御されている産業用ロボットや自動運転車などに活用するにはハードウェアの制限があり、 ハードウェアのコストと計算性能のトレードオフという課題 がありました。また、従来のAIはクラウドサーバーと通信を行うため、その際に生じる通信遅れが、リアルタイム性を必要とする用途においては致命的な課題でありました。その他にも、クラウドに大量のデータをアップロードする際に使用するネットワーク帯域、データ処理に伴う消費電力の増大、セキュリティ上の都合でクラウドにデータを上げたくないといった問題があります。

これらの問題を解消する手段として、 より現場に近いエッジデバイス側でデータ処理を行うエッジAIが必要 とされ、様々な産業におけるニーズが高まっています。

このように現在、エッジAIへの期待が高まりを見せる中、エイシングは他社にない独自のエッジAIアルゴリズムの研究・開発力とハードウェアに実装するための組み込み技術を持ち、エッジAI領域のパイオニアとして事業を展開しています。

従来のAIとエッジAIの違い

従来のAI

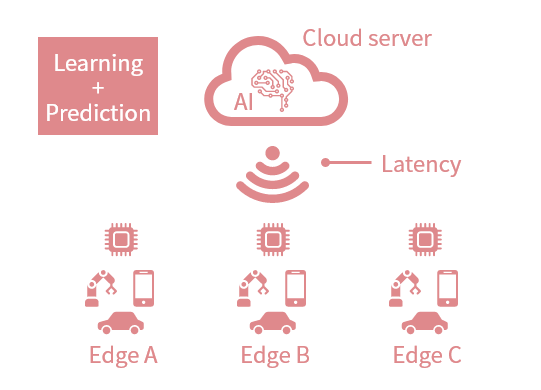

従来のディープラーニングをはじめとするAIは、クラウドサーバー側でデータの学習と予測を行い、末端のエッジデバイスとの間で通信を行うという仕組みです。クラウド側で処理を行う仕組みから、クラウドAIと呼ぶこともできます。

この仕組みにおいては、クラウドサーバーの豊富なコンピュータリソースを用いることができますが、

AIによる予測を行った後のプロセスで通信が発生するため、この際の通信遅れが致命的な問題になるようなリアルタイム性が求められる場面では使うことができません

でした。

とはいえクラウドであれば大量のデータ処理が可能であるため、

通信が遅れても問題が生じない用途においては、非常に表現力の高いAIアルゴリズムであるディープラーニングなどは適している

と言えます。

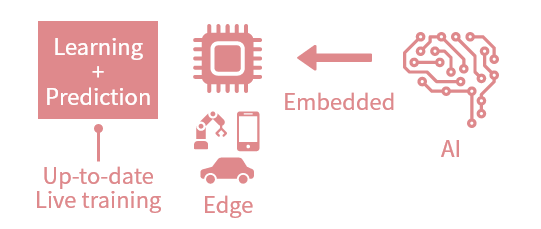

エッジAI

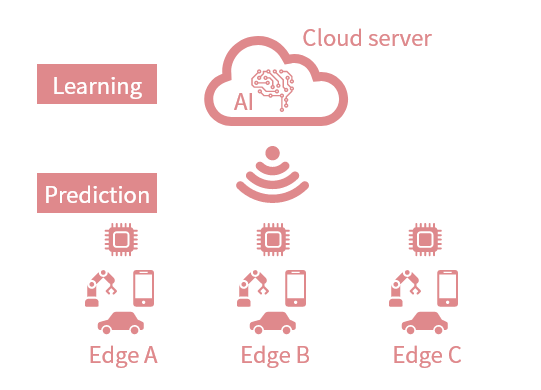

従来のAIにおいて

クラウド側で行っていた予測をエッジデバイス側で行うようにしたAIを、エッジAIと呼びます。

この仕組みにおいては、クラウド側のAIで学習した結果として生成される学習モデルをエッジ側に置くことにより、予測のみをエッジ側で処理することができます。

予測をエッジ側で行うことにより、従来のAIにおける通信遅れなどの問題を解消

することができます。例えばAIを機械の制御に用いるケースにおいては、予測をエッジ側で行うことができれば、予測から制御のプロセスにおいては通信が介在しないため、通信遅れが問題になることはありません。

このようなエッジAIを活用することにより、より末端の機器(エンドポイント)側でデータ処理を行い、

産業用機械や自動運転車などに必要とされるリアルタイム性を確保

することができます。

しかしクラウド側でデータの学習を行うため、セキュリティ上の問題でクラウドにデータを上げたくないといったニーズに対しては課題が残ります。またデータの学習を行ってから学習モデルをエッジ側に生成する際には通信が必要とされるため、

学習から予測までを完結してリアルタイムに行うことはできません。

エイシング独自のエッジAI技術

エッジデバイス側で予測だけではなく学習まで行うことができるエッジAIを、エイシングでは開発

しています。

この技術を用いる場合は、学習のためのクラウドサーバーすら必要とせず、エッジデバイス側でデータ処理を完結して行うことが可能です。また従来のディープラーニングのようにGPUなどのリッチなコンピュータでの並列計算を必要としません。

エッジデバイス側のマイコン等に直接組み込むことができる超軽量なAI

です。

これにより、従来のAIにおける通信遅れなどの問題をクリアするとともに、クラウドサーバーやGPUといったリッチなコンピュータリソースが使えないエンドポイント機器においてもAIが活用できます(エンドポイントAI)。

また

当社独自のAIソリューション"AiiR(AI in

Real-time)"の備える逐次・リアルタイム学習の機能により、エッジデバイス側で動的な環境の変化(Concept drift)に追従することが可能

です。

エッジデバイスの現状とエッジAIに求められる要件

昨今では、NVIDIAのJetson [1] など、エッジ側でのディープラーニングの並列処理にも適したGPU搭載のチップが開発されています。またGoogleもディープラーニング向けにTPU(Tensor Processing Unit)[2] を開発し、Arm®もディープラーニングの予測に使えるAIチップを開発している [3] など、各社が様々な産業用途に対してアプローチするために専用ハード開発に鎬を削っています。

一方で、産業用ロボットや自動運転車、家電などの制御においては、GPUのようなリッチなハードウェアは使われておらず、安価で低スペックなマイコンが使われていることがほとんどです。特にCortex®-MのようなCPUはGPUなどに比べて非常に多くの数が流通し、産業の隅々で使われているため、これらのハードウェアでAIが使えるようになることは大きな意味を持っています。

これらのマイコンは大量に使われるために、必要な性能を持った上でより安価であることが求められます。従って、これらの機器にAIを導入するには、より低スペックなマイコンでもデータ処理が行える必要があります。

当社はこのようなマイコンでも学習・予測を行うことができる超軽量なAIを開発しており、またCPUの処理性能の向上、小型化、低消費電力化といったハードウェアの進歩が、産業用途でのエッジAI活用を支えています。

[1] https://www.nvidia.com/en-us/autonomous-machines/embedded-systems/

[2] https://cloud.google.com/edge-tpu/

[3] https://www.arm.com/en/products/silicon-ip-cpu/ethos/ethos-u65